1爬虫学院 cuiqingcaicom由崔庆才老师创办,面向中文用户,提供全面教程与实战案例,覆盖爬虫基础框架应用及反爬策略2Python爬虫学习系列教程 runoobcompython3pyth菜鸟教程专为初学者设计,包含基础爬虫知识及实际案例,助你轻松入门3Scrapy官方文档 Scrap。

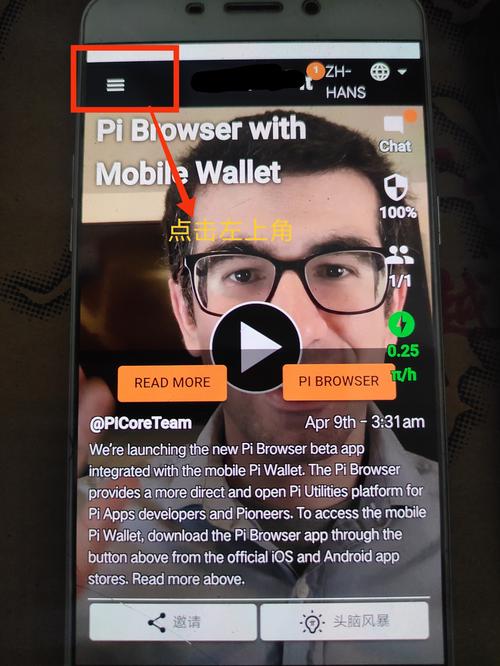

3现有的项目 google project网站有一个项目叫做sinawler,就是专门的新浪微博爬虫,用来抓取微博内容网站上不去,这个你懂的不过可以百度一下“python编写的新浪微博爬虫现在的登陆方法见新的一则微博“,可以找到一个参考的源码,他是用python2写的如果用python3写,其实可以使用urllib。

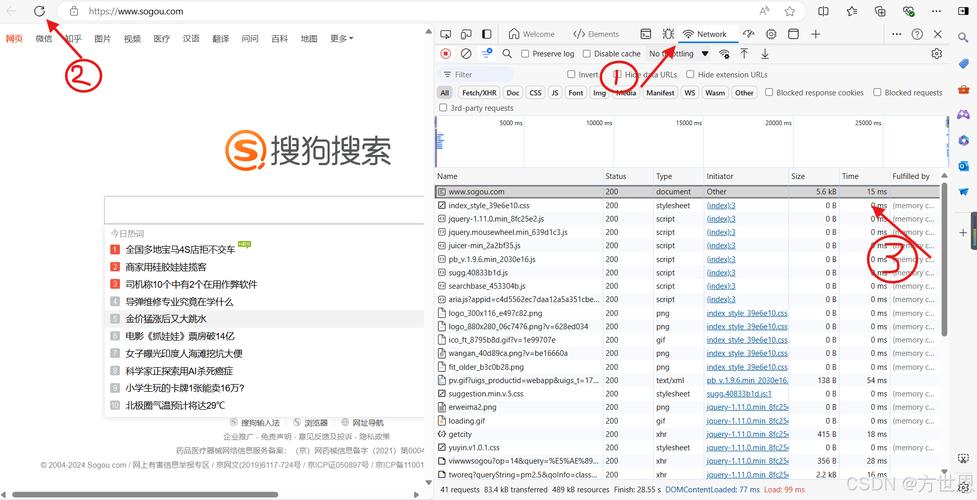

本文章旨在探讨Python爬虫技术,针对基于JavaScript加密的商品信息抓取问题进行深入解析目标网站为,其商品链接加密处理为破译此加密,首先进行抓包分析,发现数据加密与响应利用F12中的Debugger,通过Hook计时器或构造函数方法,定位请求数据与响应数据加密处理的关键点断点设置于productdetail。

requests库中的get和post方法默认的UserAgent标识了请求来源,这可能会暴露为Python爬虫,从而触发网站的反爬策略因此,我们需要自定义headers,尤其是UserAgent,使其看起来像是浏览器请求例如,通过访问。

1首先,打开原网页,如下,这里假设要爬取的字段包括昵称内容好笑数和评论数2然后针对以上网页结构,我们就可以直接编写爬虫代码,解析网页并提取出我们需要的数据了,测试代码如下,非常简单,主要用到requests+BeautifulSoup组合,其中requests用于获取网页源码,BeautifulSoup用于解析网页提取数据动态网。

对于Python+requests爬取网站遇到中文乱码的问题,您可以1 设置编码在使用requests库发送请求时,可以通过设置`responseencoding`来指定网页的编码方式,例如`responseencoding = #39utf8#39`这样可以确保获取到的网页内容按照指定的编码进行解码,避免中文乱码问题2 使用自动识别功能八爪鱼采集器。